이 편은 단순히 mysql -> elsticsearch 데이터를 넣는걸을 다룰 것이고, 심화 과정은 차후에 다루고자 한다.

자아아아~~~~!! ElasticSearch 와 Kibana가 정상적으로 시작을 하였다면 데이터를 수집해보자!!

필자는 mysql에 임의의 데이터를 입력 한 후 수집하겠다.

1) 파일복제

D:\elk\logstash-7.9.1\config\logstash-sample.conf 파일이 존재하는데 해당 파일을 복제하여

test.conf 파일을 만든다.

2) .conf 설정

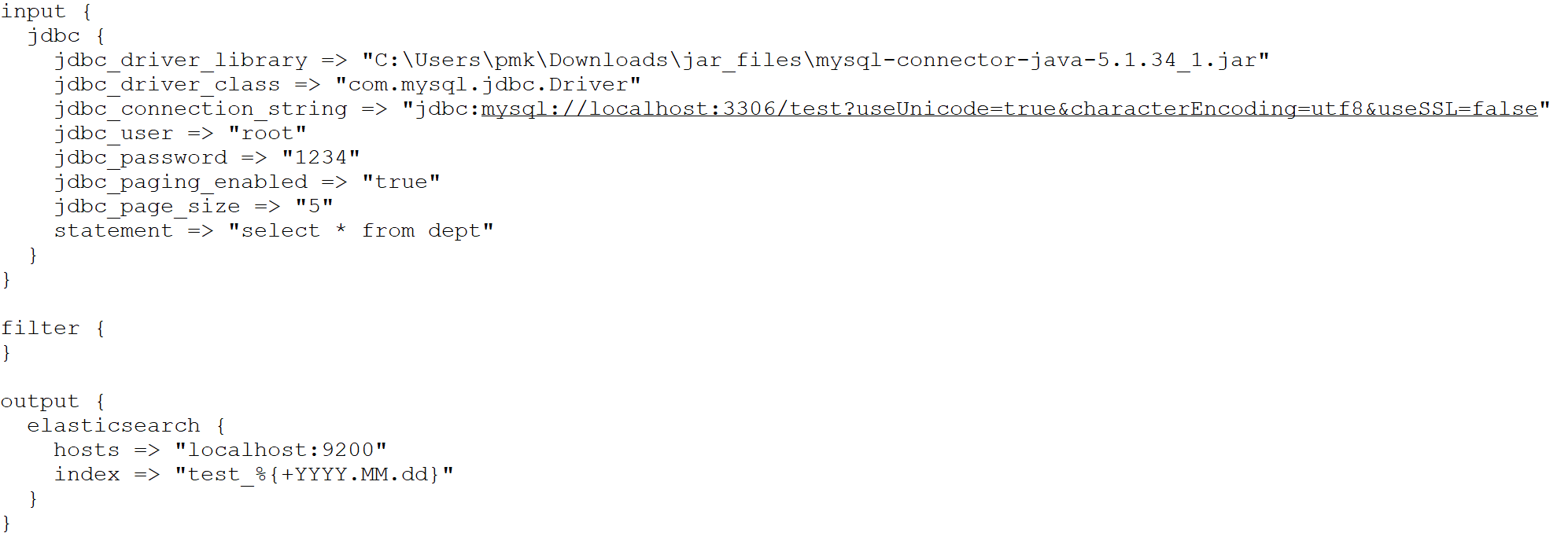

수집 설정은 input(수집대상), filter(필터링), output(저장대상) 크게 세가지로 나뉜다.

input 설정은 아래의 공홈에서 가이드를 보며 설정해보자!

www.elastic.co/guide/en/logstash/current/plugins-inputs-jdbc.html

Jdbc input plugin | Logstash Reference [7.9] | Elastic

Building count queries around a prepared statement is not supported at this time and because jdbc paging uses count queries under the hood, jdbc paging is not supported with prepared statements at this time either. Therefore, jdbc_paging_enabled, jdbc_page

www.elastic.co

상세설명은 공홈에서 확인하면 된다.

설정은 아래와 같다.

대상의 데이터가 많을 경우 설정을 하게 되는데 select 값이 천건이라고 가정하면 page size를 조절하여 데이터를 수집할 수 있도록 해준다.(최대값 100,000)

jdbc_paging_enabled => "true" #default는 false

jdbc_page_size => "5"

이씨!! tstory는 소스 붙여넣기는 왜 안되는거냐...--^

자..그럼 설정은 끝났다.

3) 수집

수집을 실행하기에 앞서.. 이거 은근모르는 사람이 많아서 꿀팁하나!!

cmd 에서 원하는 디렉토리를 이동하고자 할때 cd\대상 하면 되지만.. 탐색기를 원하는 디렉토리에 바로 가는 방법도 있다.

탐색기를 열고 원하는 디렉토리로 이동한 후 아래와 같이 주소창을 클릭해주면 블럭이 된다. 그 상태에서 cmd로 하면

바로 cmd 창이 뜨고 해당위치로 이동하게 된다.

실행) bin\logstash -f config\test.conf

자 수집은 정상적으로 이뤄졌으니 Kibana에서 데이터를 확인해보자

Kibana를 접속 후 좌측메뉴에 Management > Dev Tools 에서 명령어를 이용하여 확인한다

내가 전문가라하면 dev tool을 이용할 줄 알아야 ..크흠..

실행) GET _cat/indices?s=index&v

test_2020.10.06 index가 생성되는 것을 확인이 되고 docs.cout가 8건 모두 수집이 된 것을 확인이 된다.

dev tool외에 다른 메뉴에서도 가능하다 이 부분은 kibana 심화단계에서 상세히 설명하겠다.

자..그러면..kibana가 없으면 확인이 안되나요 라는 생각이들 수 있다..아니다..

Curl 명령어 통하거나 url에 명령어를 입력하여 확인도 가능하다

'01.Computer > ELK' 카테고리의 다른 글

| 07.Kibana_인덱스패턴(indexPatterns) (0) | 2020.10.08 |

|---|---|

| 06. Kibana_Security(로그인기능) (0) | 2020.10.07 |

| 04.Elasticsearch + Kibana Windows services 등록하기 (0) | 2020.10.05 |

| 03.ElasticSearch + Kibana 실행 (0) | 2020.09.24 |

| 02.ELK 설치 (0) | 2020.09.21 |